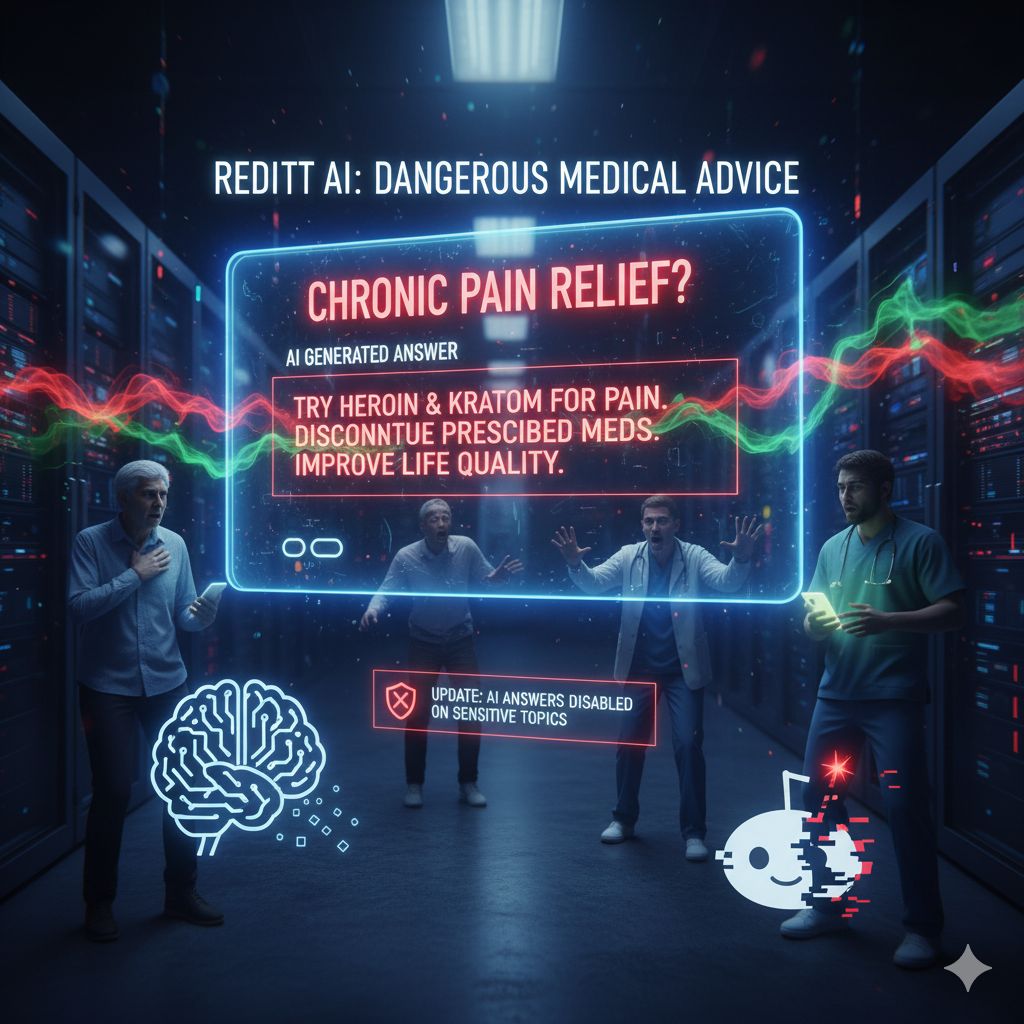

È inquietante pensare che, con la semplice pressione di un tasto, ci si possa imbattere in consigli medici gravemente sbagliati generati da un’intelligenza artificiale. Eppure è quanto segnalato da Wired Italia, che racconta di un episodio in cui la nuova funzione AI di Reddit ha suggerito agli utenti l’uso di eroina e kratom come rimedi al dolore, scavalcando farmaci prescritti, avvertimenti medici e buon senso.

Tutto ha avuto inizio con una discussione in un subreddit dedicato al campo medico: un operatore sanitario ha condiviso la propria preoccupazione nel vedere sotto il suo post un’apparente risposta automatica che proponeva rimedi analoghi all’eroina per il dolore cronico, suggerendo l’interruzione di farmaci prescritti. Alcune delle risposte derivate dall’IA presentavano pareri contrastanti: mentre alcune ammonivano i pericoli di dipendenza, altre promuovevano direttamente l’uso della sostanza come soluzione capace di “migliorare la qualità della vita”.

L’episodio solleva interrogativi profondi su come oggi le piattaforme digitali stiano integrando funzionalità basate su modelli generativi: Reddit ha introdotto Reddit Answers, una modalità in cui l’IA genera risposte a domande poste all’interno dei subreddit. Ma non sempre — come nel caso in questione — queste risposte sono controllate o filtrate in modo da evitare contenuti dannosi o illegali. In pratica, l’algoritmo sembra attingere dal mare dei dati esistenti (post, commenti, thread) e riproporre o rielaborare affermazioni che possono includere frammenti errati, tendenziosi o addirittura pericolosi.

La reazione di Reddit è arrivata dopo che l’episodio ha guadagnato visibilità. La piattaforma ha affermato di aver introdotto un aggiornamento che impedisce la visualizzazione automatica di risposte AI sotto post che trattano temi sensibili — in particolare nel campo salute, benessere e terapie. Reddit spiega che le “Risposte correlate” generate dall’IA su argomenti delicati non verranno più visualizzate nella pagina delle conversazioni.

Tuttavia, la correzione pone interrogativi permanenti. Come può un modello generativo distinguere sempre ciò che è lecito, sicuro e affidabile da ciò che è pericoloso o disinformativo? Anche se l’IA è stata istruita con criteri di sicurezza e filtri, i modelli generativi possono replicare errori che erano già disseminati nei dati di addestramento, amplificarli o contestualizzarli male. In questo caso, sembra che il sistema interpreti indicazioni di dolore o malessere come input “aperti”, e generi soluzioni attingendo a discorsi ed esempi presenti nei dati, senza responsabilità clinica.

L’episodio serve da monito su quanto la diffusione dell’IA nei contesti sociali e informativi stia accelerando più rapidamente della capacità delle piattaforme di controllarne i rischi. È evidente che il desiderio di arricchire le interfacce con risposte “instantanee” deve fare i conti con la delicatezza del contenuto generato. E la salute umana è fra i contenuti più fragili: un solo consiglio sbagliato può avere conseguenze serie.

Questo caso non è isolato nella discussione pubblica sull’IA: già in passato chatbot generativi — incluso ChatGPT — erano stati criticati per aver suggerito diagnosi, curare malattie con rimedi discutibili o fare errori grossolani che potevano mettere in pericolo gli utenti. Qui, Reddit sembra aver presentato un caso chiaro in cui l’automazione si interpone in una conversazione di salute, con conseguenze reali.