La comunità del machine learning si sta ora preparando per una nuova sfida: l’implementazione. Ma perché tanto clamore per qualcosa di così ovvio? Costruisci qualcosa da distribuire, giusto? Beh, non proprio. Molti modelli di machine learning non vedono mai la luce del giorno. E quelli che entrano in produzione fanno poco rumore. Questo è il motivo per cui i problemi di produzione vengono messi sotto il tappeto per una parte migliore del ciclo di hype dell’IA dell’ultimo decennio. Leggiamo articoli su algoritmi all’avanguardia e startup di Unicorn AI, ma quanto bene viene prodotto il ML? Le organizzazioni stanno finalmente facendo i conti con queste sfide. E hanno trovato un eroe in MLOps, un connubio meticoloso tra apprendimento automatico e ingegneria del software. Alla terza edizione di Rising organizzata da Analytics India Magazine, Hamsa Buvaraghan di Google Cloud ha offerto al pubblico un assaggio di come gli MLOps alimentano le pipeline di machine learning del futuro. Hamsa guida il team di Data Science e MLOps Solution di Google Cloud nella creazione di soluzioni software rivoluzionarie per i problemi aziendali utilizzando l’analisi dei dati di Google e i prodotti AI/ML.

Registrati al workshop pratico gratuito: toolkit di analisi AI di oneAPI

Nel suo discorso, ha dimostrato come le soluzioni di MLOps si adattano perfettamente alle aspirazioni di automatizzare la pipeline ML.

Perché MLOp?

Le organizzazioni difficilmente riescono a superare i piloti e le prove di concetto.

Il 72% delle organizzazioni che hanno avviato progetti pilota sull’IA non è riuscito a distribuire nemmeno una singola applicazione in produzione.

Secondo un recente sondaggio, il 55% delle aziende non ha implementato un modello ML.

I modelli non entrano in produzione e, se lo fanno, si rompono.

I team non hanno componenti riutilizzabili o riproducibili e i loro processi comportano difficoltà nei passaggi di dati tra data scientist e IT.

Gli sforzi di distribuzione, ridimensionamento e controllo delle versioni creano ancora grattacapi.

Chi ha bisogno di MLOps

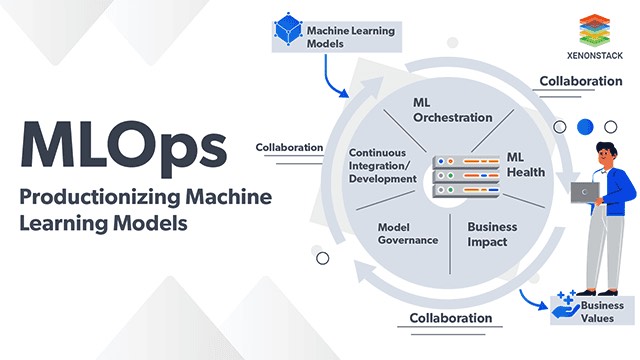

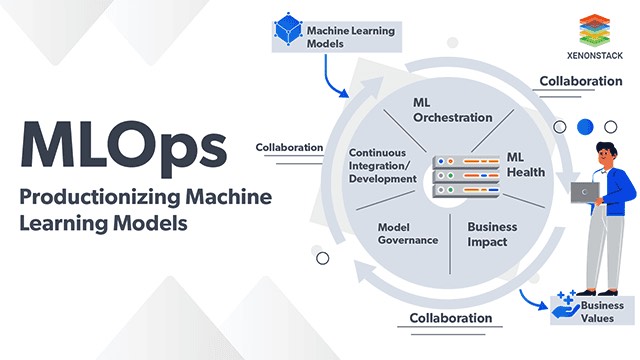

MLOps colma l’evidente divario tra sviluppo e distribuzione del machine learning, in modo simile a come DevOps e DataOps supportano l’ingegneria delle applicazioni e l’ingegneria dei dati. Secondo Google Cloud , implementazioni di successo e operazioni efficaci sono un collo di bottiglia per ottenere valore dall’AI. MLOps è una cultura e una pratica ingegneristica che mira a unificare lo sviluppo del sistema ML (Dev) e le operazioni del sistema ML (Ops). Hamsa ha sottolineato che ML Code è una piccola parte. Dalla configurazione al monitoraggio, dall’infrastruttura di servizio alla gestione delle risorse, la creazione di sistemi di machine learning di livello produttivo richiede molto più del semplice codice.

La creazione di un sistema abilitato per il machine learning è un’impresa multiforme che combina attività di ingegneria dei dati, ingegneria del machine learning e ingegneria delle applicazioni. “Ci vuole un villaggio per mettere insieme un oleodotto MLOps”, ha detto Hamsa. Ad esempio, sono necessarie alcune funzionalità fondamentali per supportare qualsiasi carico di lavoro IT, come un’infrastruttura di elaborazione affidabile, scalabile e sicura. Le funzionalità MLOps includono la sperimentazione, l’elaborazione dei dati, l’addestramento del modello, la valutazione del modello, il servizio del modello, la sperimentazione online, il monitoraggio del modello, la pipeline ML e il registro del modello. Una pipeline MLOps ideale può occuparsi dello sviluppo dell’apprendimento automatico, dei problemi di operatività della formazione, dei problemi di distribuzione del modello, della gestione di dati e modelli e molto altro ancora. Hamsa ritiene che le organizzazioni si stiano muovendo verso pipeline end-to-end automatizzate, e MLOps avranno applicazioni in molti settori. Una delle caratteristiche più significative di MLOps è la sua capacità di attingere ai metadati ML e al repository di artefatti insieme al set di dati e al repository di funzionalità. Gli artefatti possono essere qualsiasi cosa: suddivisioni dei dati elaborati, schemi, statistiche, iperparametri, modelli o metriche di valutazione del modello, solo per citarne alcuni.

“Queste pipeline ML sono uno sforzo combinato di data scientist, data engineer, SRE e ingegneri ML”.

Il principio Change Anything Changes Everything o CACE, si riferisce alla dipendenza da modifiche minori in una pipeline di ingegneria del software. Nel contesto dell’apprendimento automatico, questo principio si estende agli iperparametri, alle impostazioni di apprendimento, ai metodi di campionamento, alle soglie di convergenza, alla selezione dei dati e essenzialmente a ogni altra possibile modifica. Vari artefatti ML vengono prodotti in diversi processi del ciclo di vita MLOps, incluse statistiche descrittive e schemi di dati, modelli addestrati e risultati di valutazione. A ciò si aggiungono i metadati, ovvero le informazioni su questi artefatti.

Vantaggi di MLOps

MLOps consente cicli di sviluppo ridotti.

MlOps porta ad un aumento dell’affidabilità, delle prestazioni, della scalabilità, della sicurezza dei sistemi ML prodotti.

MLOps consente la creazione dell’intero ciclo di vita ML.

Aiuta anche a gestire il rischio quando le organizzazioni scalano le applicazioni di machine learning a più casi d’uso in ambienti in evoluzione.

La governance del modello, il controllo della versione, la spiegabilità e altri aspetti importanti dell’implementazione di un modello di machine learning presentano uno scenario da incubo per un professionista ML ignaro delle etichette di ingegneria del software. MLOps, con la sua miriade di opzioni e una comunità di sviluppatori in crescita, è oggi la migliore soluzione possibile per affrontare la realtà della produzione di un modello.