Meta Llama Open Source contro ChatGPT

Potrebbe un membro del regno dei camelidi emergere come il protagonista dell’epopea dell’intelligenza artificiale del 2023? Il riferimento è al Llama di Meta, il gigante dei modelli linguistici che ha…

In che modo i pregiudizi umani compromettono le soluzioni basate sull’intelligenza artificiale

Lo scorso settembre, una riunione di alto livello ha avuto luogo a Washington DC, coinvolgendo personalità di spicco come Elon Musk, Mark Zuckerberg e Sam Altman, CEO di OpenAI. L’agenda…

Illuminare l’Intelligenza Artificiale: Strategie di Prompt Engineering di Google DeepMind

Il prompt engineering è una disciplina che mira a ottimizzare i suggerimenti forniti ai modelli di linguaggio avanzati come GPT-4, allo scopo di elicitarne risposte più accurate e mirate. La…

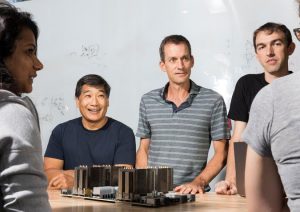

Shield AI raccoglie 200 milioni di dollari

Shield AI: Finanziamento Record e Aspirazioni di Avanguardia Shield AI, leader nell’innovazione di piloti AI per aeromobili, ha confermato l’acquisizione di un finanziamento di 200 milioni di dollari nel corso…

VanceAI e il suo AI Sketch to Image Generator

VanceAI e la Rivoluzione nell’E-commerce attraverso la Generazione di Immagini di Prodotto VanceAI ha lanciato il suo innovativo strumento, il “Generatore di Immagini di Prodotto AI”, che integra il “Generatore…

Marketing su misura per le PMI: il Product Studio AI-driven di Google crea contenuti natalizi

Google ha lanciato un nuovo set di strumenti per la creazione di contenuti visivi attraverso il suo Product Studio AI-driven, offrendo alle piccole imprese soluzioni per promuovere i loro prodotti…

Conto alla rovescia per OpenAI DevDay 2023: cosa aspettarsi lunedì 6 novembre

OpenAI si prepara a tenere il suo primo DevDay questo lunedì 6 novembre, puntando i riflettori sul keynote delle 13:00 EST / 10:00 PST. Le aspettative sono elevate per quello…

Esplora le nuove frontiere di LinkedIn Premium potenziate dall’IA Generativa

LinkedIn ha potenziato le capacità della sua offerta Premium introducendo nuove funzionalità basate sull’intelligenza artificiale generativa, volte a personalizzare e ottimizzare l’esperienza degli utenti per massimizzare la loro produttività. La…

IBM lancia Watsonx Code Assistant, il Generative AI Coding Assistant per lo sviluppo aziendale

IBM ha annunciato il lancio di un avanzato strumento di AI generativo per la programmazione, denominato Watsonx Code Assistant. Questo nuovo componente della serie di prodotti Watsonx dedicati all’AI generativa…

Come usare Tenorshare AI Chat PDF

Tenorshare AI Chat PDF: L’evoluzione nella lettura dei PDF Stai cercando un modo più agile per affrontare lunghi documenti PDF? La soluzione potrebbe essere arrivata con la recente introduzione di…