Sfruttare al massimo poco: migliorare l’addestramento dell’IA per le serie temporali dei sensori perimetrali

Aumento integrato dei dati per le serie temporali dell’accelerometro nel riconoscimento del comportamento: ruoli di campionamento, bilanciamento e surrogati di Fourier

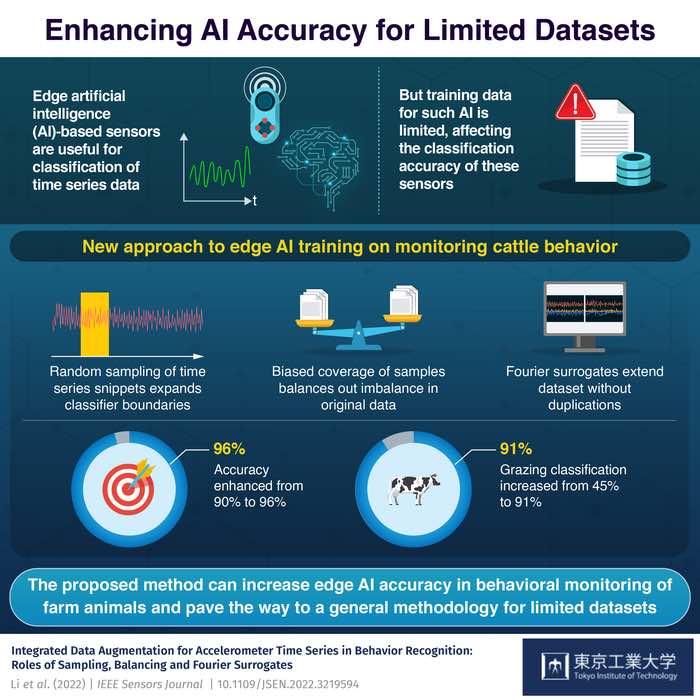

Gli ingegneri del Tokyo Institute of Technology (Tokyo Tech) hanno dimostrato un semplice approccio computazionale per migliorare il modo in cui i classificatori di intelligenza artificiale, come le reti neurali, possono essere addestrati sulla base di quantità limitate di dati dei sensori. Le applicazioni emergenti dell’internet delle cose richiedono spesso dispositivi edge in grado di classificare in modo affidabile comportamenti e situazioni basati su serie temporali. Tuttavia, i dati di addestramento sono difficili e costosi da acquisire. L’approccio proposto promette di aumentare sostanzialmente la qualità della formazione del classificatore, quasi senza costi aggiuntivi.

Negli ultimi tempi, la prospettiva di disporre di un numero enorme di sensori Internet of Things (IoT) che monitorano silenziosamente e diligentemente innumerevoli aspetti delle attività umane, naturali e delle macchine ha guadagnato terreno. Man mano che la nostra società diventa sempre più affamata di dati, scienziati, ingegneri e strateghi sperano sempre più che le informazioni aggiuntive che possiamo ricavare da questo monitoraggio pervasivo miglioreranno la qualità e l’efficienza di molti processi produttivi, con conseguente miglioramento della sostenibilità.

Il mondo in cui viviamo è incredibilmente complesso e questa complessità si riflette in un’enorme moltitudine di variabili che i sensori IoT possono essere progettati per monitorare. Alcuni sono naturali, come la quantità di luce solare, l’umidità o il movimento di un animale, mentre altri sono artificiali, ad esempio il numero di auto che attraversano un incrocio o lo sforzo applicato a una struttura sospesa come un ponte. Ciò che tutte queste variabili hanno in comune è che si evolvono nel tempo, creando ciò che è noto come serie temporali e che le informazioni significative dovrebbero essere contenute nei loro incessanti cambiamenti. In molti casi, i ricercatori sono interessati a classificare un insieme di condizioni o situazioni predeterminate basate su questi cambiamenti temporali, come un modo per ridurre la quantità di dati e renderli più facili da capire. Per esempio,

Alcuni tipi di sensori misurano variabili che di per sé cambiano molto lentamente nel tempo, come l’umidità. In tali casi, è possibile trasmettere ogni singola lettura tramite rete wireless a un server cloud, dove avviene l’analisi di grandi quantità di dati aggregati. Tuttavia, sempre più applicazioni richiedono la misurazione di variabili che cambiano piuttosto rapidamente, come le accelerazioni che seguono il comportamento di un animale o l’attività quotidiana di una persona. Poiché spesso sono necessarie molte letture al secondo, diventa poco pratico o impossibile trasmettere i dati grezzi in modalità wireless, a causa delle limitazioni dell’energia disponibile, dei costi dei dati e, in località remote, della larghezza di banda. Per aggirare questo problema, gli ingegneri di tutto il mondo sono da tempo alla ricerca di modi intelligenti ed efficienti per estrarre aspetti dell’analisi dei dati dal cloud e portarli negli stessi nodi dei sensori. Questo è spesso chiamato edge artificial intelligence o edge AI. In termini generali, l’idea è quella di inviare in modalità wireless non le registrazioni grezze, ma i risultati di un algoritmo di classificazione alla ricerca di particolari condizioni o situazioni di interesse, ottenendo una quantità di dati molto più limitata da ciascun nodo.

Ci sono, tuttavia, molte sfide da affrontare. Alcuni sono fisici e derivano dalla necessità di inserire un buon classificatore in quello che di solito è una quantità piuttosto limitata di spazio e peso, e spesso facendolo funzionare con una quantità di energia molto ridotta in modo da ottenere una lunga durata della batteria. “Ogni giorno emergono buone soluzioni ingegneristiche per questi requisiti, ma la vera sfida che frena molte soluzioni del mondo reale è in realtà un’altra. L’accuratezza della classificazione spesso non è abbastanza buona e la società richiede risposte affidabili per iniziare a fidarsi di una tecnologia”, afferma il dott. Hiroyuki Ito, capo della Nano Sensing Unit in cui è stato condotto lo studio. “Molte applicazioni esemplari dell’intelligenza artificiale come le auto a guida autonoma hanno dimostrato che quanto sia buono o scarso un classificatore artificiale dipende fortemente dalla qualità dei dati utilizzati per addestrarlo. Ma, il più delle volte, i dati delle serie temporali dei sensori sono davvero impegnativi e costosi da acquisire sul campo. Ad esempio, considerando il monitoraggio del comportamento del bestiame, per acquisirlo gli ingegneri devono trascorrere del tempo nelle fattorie, strumentare le singole mucche e avere esperti che annotano pazientemente il loro comportamento sulla base di riprese video”, aggiunge il coautore Dr. Korkut Kaan Tokgoz, già parte dello stesso unità di ricerca e ora con l’Università Sabanci in Turchia.

Come conseguenza del fatto che i dati di addestramento sono così preziosi, gli ingegneri hanno iniziato a cercare nuovi modi per ottenere il massimo anche da una quantità piuttosto limitata di dati disponibili per addestrare dispositivi IA all’avanguardia. Una tendenza importante in questo settore è l’utilizzo di tecniche note come “data augmentation”, in cui alcune manipolazioni, ritenute ragionevoli in base all’esperienza, vengono applicate ai dati registrati in modo da cercare di imitare la variabilità e l’incertezza che si possono incontrare nelle applicazioni reali. “Ad esempio, nel nostro lavoro precedente, abbiamo simulato la rotazione imprevedibile di un collare contenente un sensore di accelerazione attorno al collo di una vacca monitorata e abbiamo scoperto che i dati aggiuntivi generati in questo modo potrebbero davvero migliorare le prestazioni nella classificazione del comportamento”, spiega La signora Chao Li, dottoranda e autrice principale dello studio [1]. “Tuttavia, ci siamo anche resi conto che avevamo bisogno di un approccio molto più generale per aumentare le serie temporali dei sensori, che in linea di principio potesse essere utilizzato per qualsiasi tipo di dati e non fare ipotesi specifiche sulla condizione di misurazione. Inoltre, nelle situazioni del mondo reale, ci sono in realtà due questioni, correlate ma distinte. Il primo è che la quantità complessiva di dati di addestramento è spesso limitata. La seconda è che alcune situazioni o condizioni si verificano molto più frequentemente di altre, e questo è inevitabile. Ad esempio, le mucche passano naturalmente molto più tempo a riposare o ruminare che a bere. Tuttavia, misurare con precisione i comportamenti meno frequenti è essenziale per giudicare correttamente lo stato di benessere di un animale. Una mucca che non beve sicuramente soccomberà, anche se l’accuratezza della classificazione del bere può avere un impatto limitato sugli approcci di allenamento comuni a causa della sua rarità. Questo è chiamato il problema dello squilibrio dei dati”, aggiunge.

La ricerca computazionale condotta dai ricercatori di Tokyo Tech e inizialmente mirata a migliorare il monitoraggio del comportamento del bestiame offre una possibile soluzione a questi problemi, combinando due approcci molto diversi e complementari. Il primo è detto campionamento e consiste nell’estrarre “snippet” di serie temporali corrispondenti alle condizioni da classificare partendo sempre da istanti diversi e casuali. Il numero di frammenti estratti viene regolato attentamente, assicurando che si finisca sempre con approssimativamente lo stesso numero di frammenti in tutti i comportamenti da classificare, indipendentemente da quanto siano comuni o rari. Ciò si traduce in un set di dati più bilanciato, che è decisamente preferibile come base per l’addestramento di qualsiasi classificatore come una rete neurale. Poiché la procedura si basa sulla selezione di sottoinsiemi di dati effettivi, è sicuro in termini di evitare la generazione degli artefatti che possono derivare dalla sintesi artificiale di nuovi frammenti per compensare i comportamenti meno rappresentati. Il secondo è noto come dati surrogati e prevede una procedura numerica molto robusta per generare, da qualsiasi serie temporale esistente, un numero qualsiasi di nuove serie che conservano alcune caratteristiche chiave, ma sono completamente non correlate. “Questa combinazione virtuosa si è rivelata molto importante, perché il campionamento può causare molte duplicazioni degli stessi dati, quando certi comportamenti sono troppo rari rispetto ad altri. I dati surrogati non sono mai gli stessi e prevengono questo problema, che può influire molto negativamente sul processo di formazione. E un aspetto chiave di questo lavoro è che l’aumento dei dati è integrato con il processo di formazione, quindi,

Le serie temporali surrogate vengono generate rimescolando completamente le fasi di uno o più segnali, rendendole così totalmente irriconoscibili quando si considerano i loro cambiamenti nel tempo. Tuttavia, la distribuzione dei valori, l’autocorrelazione e, in caso di segnali multipli, la correlazione incrociata, sono perfettamente conservate. “In un altro lavoro precedente, abbiamo scoperto che molte operazioni empiriche come l’inversione e la ricombinazione di serie temporali hanno effettivamente contribuito a migliorare l’addestramento. Poiché queste operazioni modificano il contenuto non lineare dei dati, in seguito abbiamo pensato che il tipo di caratteristiche lineari che vengono mantenute durante la generazione dei surrogati sono probabilmente fondamentali per le prestazioni, almeno per l’applicazione del riconoscimento del comportamento della vacca su cui mi concentro”, spiega ulteriormente la sig.ra Chao Li [2]. “Il metodo delle serie temporali surrogate proviene da un campo completamente diverso, vale a dire lo studio delle dinamiche non lineari in sistemi complessi come il cervello, per i quali tali serie temporali vengono utilizzate per aiutare a distinguere il comportamento caotico dal rumore. Mettendo insieme le nostre diverse esperienze, ci siamo presto resi conto che potevano essere utili anche per questa applicazione”, aggiunge il dott. Ludovico Minati, secondo autore dello studio e anche lui della Nano Sensing Unit. “Tuttavia, è necessaria una notevole cautela perché non esistono due scenari applicativi uguali e ciò che è vero per le serie temporali che riflettono i comportamenti delle bovine potrebbe non essere valido per altri sensori che monitorano diversi tipi di dinamiche. In ogni caso, l’eleganza del metodo proposto è che è abbastanza essenziale, semplice e generico. Pertanto, sarà facile per altri ricercatori provarlo rapidamente sui loro problemi specifici”, aggiunge.

Dopo questa intervista, il team ha spiegato che questo tipo di ricerca sarà applicato in primo luogo al miglioramento della classificazione dei comportamenti bovini, a cui era inizialmente destinato e su cui l’unità sta conducendo ricerche multidisciplinari in collaborazione con altre università e aziende. “Uno dei nostri obiettivi principali è dimostrare con successo un’elevata precisione su un dispositivo piccolo ed economico in grado di monitorare una vacca per tutta la sua vita, consentendo il rilevamento precoce della malattia e quindi migliorando davvero non solo il benessere degli animali, ma anche l’efficienza e la sostenibilità dell’allevamento” , conclude il dottor Hiroyuki Ito. La metodologia ei risultati sono riportati in un recente articolo pubblicato sulla rivista IEEE Sensors [3].

Informazioni sull’Istituto di tecnologia di Tokyo

Tokyo Tech è all’avanguardia nella ricerca e nell’istruzione superiore come principale università per la scienza e la tecnologia in Giappone. I ricercatori di Tokyo Tech eccellono in campi che vanno dalla scienza dei materiali alla biologia, informatica e fisica. Fondata nel 1881, Tokyo Tech ospita oltre 10.000 studenti universitari e laureati all’anno, che diventano leader scientifici e alcuni degli ingegneri più ricercati dell’industria. Incarnando la filosofia giapponese di “monotsukuri”, che significa “ingegnosità tecnica e innovazione”, la comunità di Tokyo Tech si impegna a contribuire alla società attraverso una ricerca ad alto impatto.

Chao Li dell’Istituto di tecnologia di Tokyo