I ricercatori del MIT hanno distribuito il controller appreso in un veicolo autonomo su vasta scala nel mondo reale dopo aver guidato con successo 10.000 chilometri in simulazione.

“Mettete un’auto sulla strada che potrebbe essere guidata dalla legge, ma rispetto agli utenti della strada circostanti, si sta comportando in modo molto prudente. Questo può portare a situazioni in cui l’auto a guida autonoma è un po’ un pesce fuor d’acqua”, ha affermato Karl Iagnemma di Motional.

I veicoli autonomi sono dotati di sistemi di controllo che imparano a emulare i controlli dello sterzo sicuri in una varietà di situazioni basati su set di dati del mondo reale di traiettorie di guida umane. Tuttavia, è estremamente difficile programmare il processo decisionale visti gli infiniti scenari possibili su strade reali. Nel frattempo, i dati del mondo reale sui “casi limite” (come il rischio di un incidente o l’essere costretti a lasciare la strada) sono difficili da trovare.

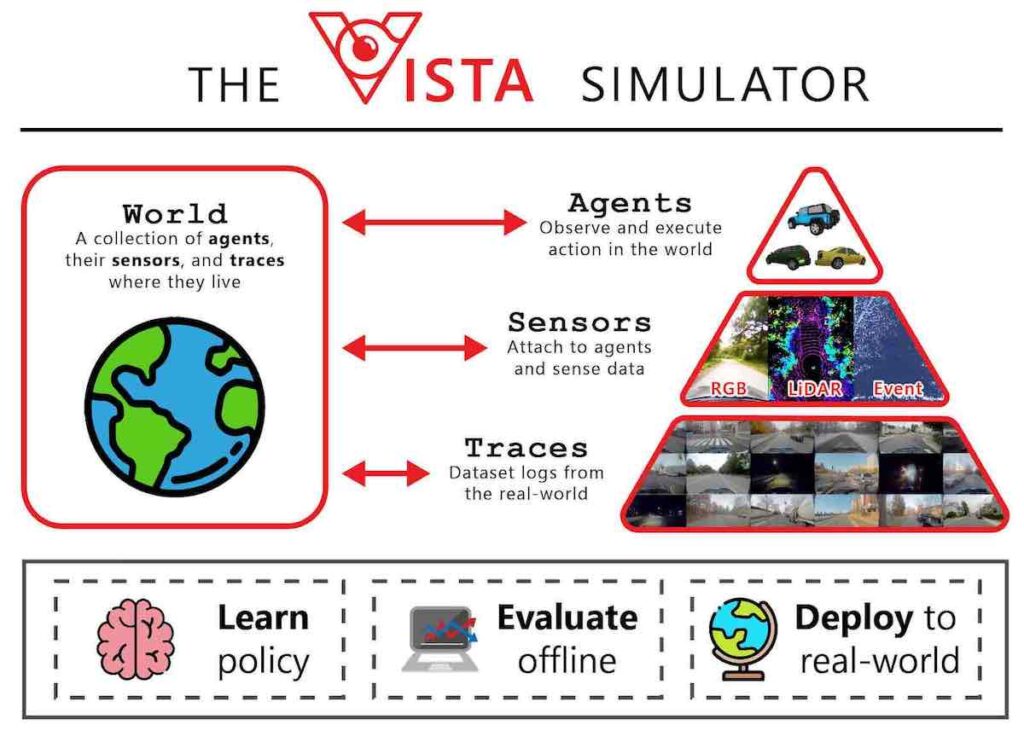

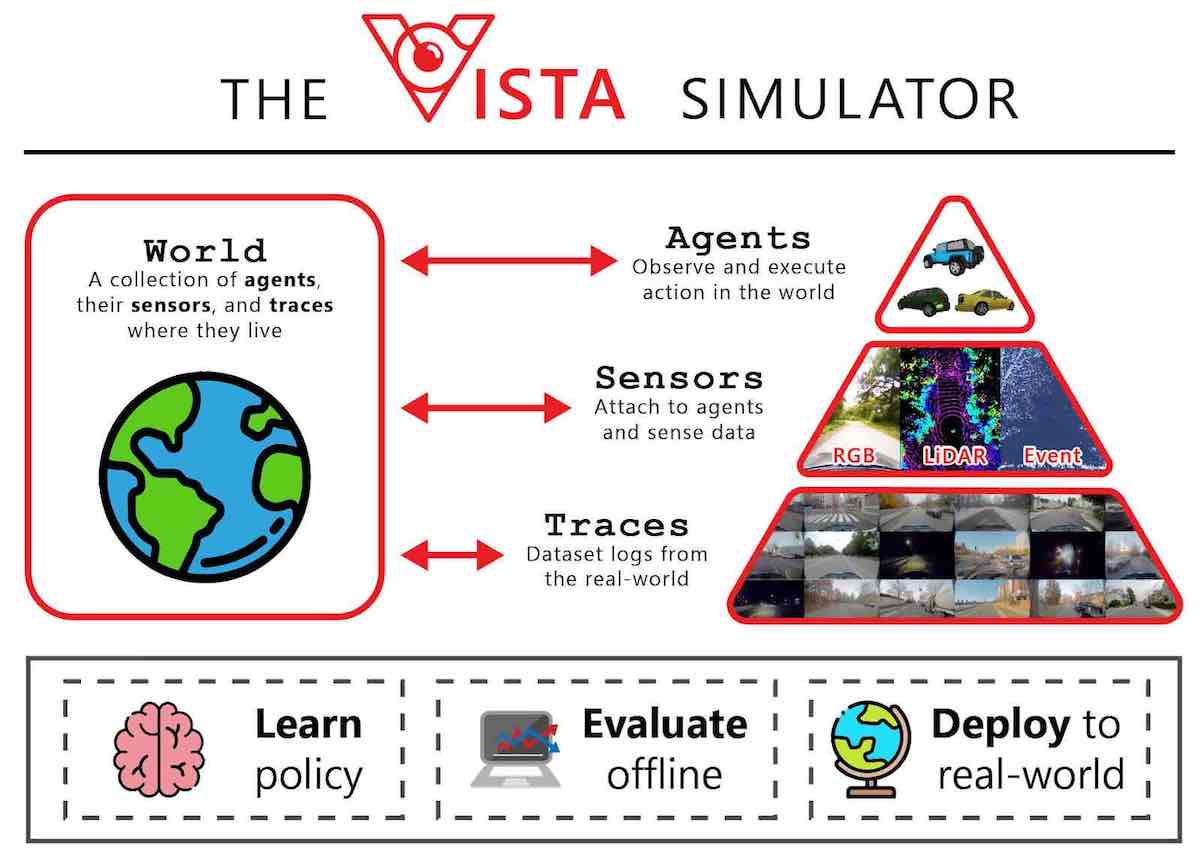

I ricercatori del MIT Computer Science & Artificial Intelligence Laboratory (CSAIL), in collaborazione con il Toyota Research Institute, hanno sviluppato un sistema di simulazione chiamato Virtual Image Synthesis and Transformation for Autonomy (VISTA) per addestrare auto senza conducente nel marzo 2020 .

VISTA ha essenzialmente creato un mondo fotorealistico con infinite possibilità di sterzata, consentendo alle auto di esercitarsi a navigare in una varietà di scenari peggiori. Ha utilizzato un piccolo set di dati catturato dagli esseri umani che guidano su una strada per generare un numero quasi infinito di nuovi punti di vista da traiettorie del mondo reale. Il controller viene premiato per la distanza che percorre senza schiantarsi, quindi deve imparare a viaggiare in sicurezza da solo. Di conseguenza, il veicolo impara a navigare in sicurezza in diverse situazioni, come riprendere il controllo dopo aver deviato tra le corsie o riprendersi da una quasi collisione.

Come funziona la simulazione basata sui dati

VISTA inizia importando i dati video della guida umana e convertendo ogni pixel in una nuvola di punti 3D per ogni fotogramma. Quando gli utenti posizionano un veicolo virtuale in quel mondo e gli fanno impartire un comando di sterzata, il motore genera una nuova traiettoria attraverso la nuvola di punti in base alla curva di sterzata e all’orientamento e alla velocità del veicolo.

Il motore utilizza quindi quella nuova traiettoria per eseguire il rendering di una scena fotorealistica. Lo fa stimando una mappa di profondità, che contiene informazioni sulla distanza degli oggetti dal punto di vista del controller utilizzando una rete neurale convoluzionale. La mappa di profondità viene quindi combinata con una tecnica che stima l’orientamento della telecamera all’interno di una scena 3D. Tutto ciò contribuisce a determinare la posizione del veicolo e la relativa distanza da tutto nel simulatore virtuale. Sulla base di questi dati, riorienta i pixel originali per creare una rappresentazione 3D del mondo dalla nuova prospettiva del veicolo. Segue anche il movimento dei pixel per catturare il movimento di auto, persone e altri oggetti in movimento nella scena.

I ricercatori del MIT hanno implementato il controller appreso in un veicolo autonomo su vasta scala nel mondo reale dopo aver guidato con successo 10.000 chilometri in simulazione. Secondo il MIT, questa è stata la prima volta che un controller addestrato alla simulazione utilizzando l’ apprendimento per rinforzo end-to-end è stato implementato con successo su un’auto autonoma su vasta scala.

Un gioco open source

Dal suo lancio iniziale nel 2020, MIT CSAIL è stato piuttosto tranquillo su VISTA. Tuttavia, questo è cambiato quando hanno lanciato VISTA 2.0 e aperto il codice. Questo lavoro è stato sostenuto dalla National Science Foundation, dal Toyota Research Institute e da NVIDIA con la donazione del Drive AGX Pegasus.

VISTA 1 supportava solo l’inseguimento di corsia di una sola auto con un sensore della telecamera. Ma per ottenere una simulazione basata sui dati ad alta fedeltà, i ricercatori del MIT hanno dovuto ripensare le basi di come possono essere sintetizzati diversi sensori e interazioni comportamentali.

VISTA 2.0 è un sistema basato sui dati in grado di simulare tipi di sensori complessi e scenari e intersezioni massicciamente interattivi su larga scala. Con meno dati rispetto ai modelli precedenti, il team è stato in grado di addestrare veicoli autonomi che potrebbero essere sostanzialmente più robusti di quelli addestrati su grandi quantità di dati del mondo reale. “VISTA 2.0 dimostra la capacità di simulare i dati dei sensori ben oltre le telecamere RGB 2D, ma anche lidar 3D di dimensioni estremamente elevate con milioni di punti, telecamere basate su eventi a tempo irregolare e persino scenari interattivi e dinamici con altri veicoli”, ha affermato CSAIL Dottorando Alexander Amini.

A fuoco: dati del sensore Lidar

In un mondo basato sui dati, i dati dei sensori Lidar sono molto più difficili da interpretare: stai effettivamente cercando di generare nuvole di punti 3D nuove di zecca con milioni di punti da viste sparse del mondo. I ricercatori del MIT hanno utilizzato i dati raccolti dall’auto per proiettarli in uno spazio 3D basato sui dati Lidar e quindi lasciare che un nuovo veicolo virtuale si spostasse localmente dal punto in cui si trovava il veicolo originale. Infine, hanno utilizzato le reti neurali per proiettare tutti quei dati sensoriali nella cornice di vista di questo nuovo veicolo virtuale.

Insieme alla simulazione di telecamere basate su eventi, che operano a velocità di migliaia di eventi al secondo, il simulatore è stato in grado di simulare queste informazioni multimodali in tempo reale, consentendo alle reti neurali di essere addestrate offline e testate online in configurazioni di realtà aumentata per valutazioni di sicurezza.

Di conseguenza, puoi muoverti nella simulazione, utilizzare diversi tipi di controller, simulare vari tipi di eventi, creare scenari interattivi e semplicemente inserire veicoli nuovi di zecca che non erano nemmeno nei dati originali. Hanno testato per seguire corsia, svoltare, seguire auto e scenari più pericolosi come il sorpasso statico e dinamico (vedere ostacoli e spostarsi per evitare collisioni). Gli agenti reali e simulati interagiscono con la multi-agenzia e nuovi agenti possono essere inseriti nella scena e controllati in qualsiasi modo.

VISTA 2.0 consente essenzialmente alla comunità di raccogliere i propri set di dati e convertirli in mondi virtuali in cui possono simulare direttamente i propri veicoli autonomi virtuali , guidare su questi terreni virtuali, addestrare veicoli autonomi in questi mondi e quindi trasferirli direttamente a dimensioni normali , vere auto a guida autonoma.

Valore aggiunto

“L’utilità dipende dalla qualità dei dati raccolti e sarebbe interessante vedere come i ricercatori utilizzano questo strumento. Tipicamente il radar è anche una fonte di dati del sensore e sarebbe interessante vedere le differenze nella qualità del mondo della simulazione con e senza di esso. In generale, questo modello funge da buon ambiente di simulazione per addestrare e testare vari modelli di IA implementati. La modellazione degli attori nell’ambiente di simulazione è sempre una sfida per l’implementazione di AV e rimane una sfida non chiaramente affrontata in questo strumento”, ha affermato un esperto di guida autonoma.

L’ambiente di simulazione è basato sui dati del mondo reale e funge da solida piattaforma su cui costruire. Il rilascio di questo set di dati e dell’ambiente per i ricercatori per la formazione e il test rimuove molte eccedenze nella creazione di piattaforme AV. Anche aziende autonome di veicoli come Waymo e Cruise hanno set di dati e strumenti open source. “Poiché la maggior parte delle aziende AV mature ha investito molto in questo sforzo e ha sviluppato strumenti interni e fa affidamento sul fatto che siano strettamente integrati nel loro processo di sviluppo. Inoltre, la dipendenza dalla propria fonte di dati, sensori e HW è fondamentale e riduce il valore di tale strumento per un’azienda matura. D’altra parte, le startup in fase inizialepotrebbe trarre vantaggio dal mostrare valore utilizzando questo framework, ma ci sono dei limiti. Ci sono anche aziende come Applied Intuition che offrono molta più stabilità e fiducia e forniscono prezzi interessanti, il che riduce direttamente il valore di un tale set di dati per i produttori di AV. Tuttavia, il più grande vantaggio per i produttori di AV da questo framework è la capacità di separare i buoni talenti dai migliori poiché gli studenti mostrano la loro abilità tecnica su queste piattaforme e possono mostrare un valore tangibile in anticipo”, ha aggiunto.